全面开放,一夜之间文生视频王者宝座易主新榜

自今年2月Sora发布后,AI视频生成赛道上的头部玩家Runway沉寂许久。

没想到,早早官宣的Sora尚在“期货”状态,Runway一出手就放大招:在北京时间7月2日凌晨宣布旗下最新文生视频模型Gen-3Alpha(以下简称Gen-3)正式面向所有用户开放使用。

体验地址已同步整理至文末

据介绍,Gen-3是Runway在其为大规模多模式训练而构建的新基础设施上训练的一系列模型中的首个发布模型。与前一代Gen-2相比,它在保真度、一致性和运动方面实现了显著提升,并向“通用世界模型”迈出了重要一步。

前几天,Runway仅向创意合作伙伴开放了Gen-3的使用权限,随后其生成的“大片”迅速在海内外社交媒体平台上刷屏,许多网友看完Gen-3生成的视频后纷纷感叹“这下不用等Sora”了。

目前,Gen-3已全面开放使用。不过现阶段仍需氪金成为付费会员后才能进行体验。

我们第一时间对其进行了实测,试着生成了80多条视频,涵盖人物、动物、风景和超现实场景等多种镜头类型,同时结合早前Runway官方演示和Sora等同赛道产品在同一提示词下的表现,看看Gen-3的实际生成效果究竟如何。

ps.在此特别鸣谢AI视频创作者、导演“闲人一坤”友情提供的Gen-3创意合作伙伴内测账号。此前,他创作的AI短片《山海奇镜》在业内颇受好评,感兴趣的玩家可前往同名视频号关注~

实测Gen-3:超强文字生成能力炸场,文生视频已经NextLevel

根据Runway创意合作伙伴早前反馈,Gen-3在文字生成类镜头上表现相当惊艳。而AI在图像中生成可控文字一直是个难题,更不用说在视频中呈现出完整、准确的文字了。

Gen-3真有那么厉害吗?话不多说,实际上手一测便知。

文字生成类镜头

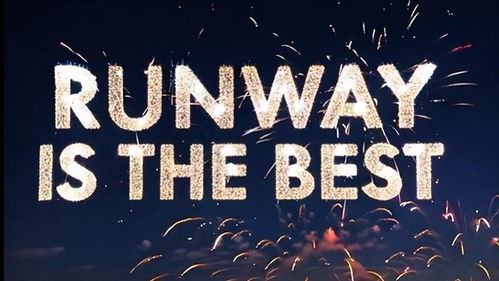

提示词:Atnight,fireworksburstinthesky,formingthewords:'Runwayisthebest.'晚上,烟花在天空中绽放形成了文字:“Runway是最好的。”将提示词中的“Runway是最好的”替换成“AI新榜”后的效果如下:

可见,Gen-3目前对中文的支持有限,但在英文文字输出方面已经相当成熟。虽然在测试过程中仍存在输出不稳定的情况,但在不超过三次“抽卡”的情况下,得到文字完整准确的视频已经足够令人惊喜。

长镜头生成

Gen-3支持生成长达10秒的多视角转换视频。

提示词:Anextremeclose-upshotofadesertlizardinalush,grassyarea.Thecamerapullsback,revealingthevastexpanseofthedesert.极近距离拍摄一只沙漠蜥蜴在郁郁葱葱的草地上。摄像机拉远,展现出沙漠的辽阔景象。在提示词中我们要求视频从大特写镜头过渡到全景镜头,最终生成的视频非常流畅且没有明显的画面瑕疵。AI生成的视频时长越长越容易“露怯”,Gen-3这轮表现相当惊艳。

人物类

一位白发戴眼镜的老先生正狼吞虎咽地吃着一个美味的奶酪汉堡。面包上撒满了芝麻,夹着新鲜的生菜、一片奶酪和一块金黄色的牛肉饼。当他咬下一口时,他的眼睛因享受而闭上。他穿着一件红色夹克,看起来像是坐在一家快餐店里。Runway:

Sora:

人物类镜头上,我们先用提示词“WillSmithEatingSpaghetti(威尔史密斯吃意大利面)”测试了一波Gen-3能否生成名人形象,全面开放,一夜之间文生视频王者宝座易主新榜得到了违反平台内容审核政策的消息提醒。

将提示词中的“WillSmith”替换成“一个男人正在吃意大利面”,才顺利生成了视频。

不过,以上两个Runway生成的人物类视频中,画面主体出现了“6指”或运动幅度过大导致的“歪脸”等常见的AI生成视频的技术瑕疵。

动物类

提示词:Anorangecatiswalkingtowardsthecamera.一只橘猫正朝镜头走来。这轮生成的视频在光影和视觉效果上相当吸睛,电影感拉满。但可惜的是,该条视频并未呈现出提示词所要求的主体运动。

考虑到可能是提示词不够详细,我们又写了多版提示词进行测试。测试结果显示,目前Gen-3仍存在和Sora一样的问题,无法理解电影拍摄术语,如“从景深处走向镜头”。

当然,由于篇幅原因我们没有测完所有电影术语。在处理“特写”“全景”等常见镜头表达方式时,Gen-3较少出错,但涉及到冷门的电影拍摄术语如希区柯克变焦(又称Dollyzoom),Gen-3就无法正确理解提示词的要求了。

提示词:Agiganticgingercatwalksalongaquietforestpath,Dollyzoom.一只巨大的橘猫沿着安静的森林小径行走,希区柯克变焦。风景及超现实类镜头

提示词:Cherryblossomsfallgentlyfromthetree,driftingslowlytotheground.Thecameracapturesthemovementofeachpetal,withasereneparkorgardeninthebackground,enhancingthescene'sbeautyandtranquility.樱花轻柔地从树上飘落,缓缓地飘向地面。摄像机捕捉每片花瓣的移动,背景是宁静的公园或花园,增强了场景的美丽与宁静。主流视频生成模型目前在风景类镜头生成上表现较为稳定。简单的日常风景难不倒这届AI,那超现实类的风景表现如何呢?

提示词:Inthemiddleoftheocean,thereisatall,burningtree.在海洋的中央,有一棵高大、燃烧着的树。在本轮测试中,Gen-3生成的视频大致上符合我们对此超现实场景的想象。画面中的细节,例如树的高度和枝叶的繁茂程度,都可以通过进一步微调提示词来实现理想的画面效果。

动画类

提示词:Ina3Danimationstyle,alittlegirliscastingamagicalspell.Thecameracaptureshermovementsasshewavesherwand,creatingsparklesandcolorfullighteffectsaroundher.在3D动画风格中,一个小女孩正在施展魔法。镜头捕捉到她挥动魔杖的动作,周围闪烁着火花和五彩缤纷的光效。最初我们喂给AI的提示词包含“皮克斯风格”,但与“威尔史密斯吃面”视频生成一样遭到了平台拒绝,之后改为“3D动画风格”才顺利生成视频。

整体视频生成效果上,5秒时长内没有出现人脸崩坏、重影等AI视频生成常见问题。只不过,细看会发现,人物手部“糊”成了一团。

官方演示vs用户实际测试

提示词:Subtlereflectionsofawomanonthewindowofatrainmovingathyper-speedinaJapanesecity.一位女士在高速行驶于日本城市的列车窗户上的微妙倒影。Runway官方演示:

“AI新榜”实测:

对比测试结果,使用相同的提示词,我们可以明显看出实测视频中的人物在镜中的反射与实际人物存在显著差异,看起来是两个不同的人。

总的来说,Gen-3在人物类镜头上整体表现不如预期。例如,生成的人物手部容易出现“6指”、运动不符合现实世界规则等,从侧面印证了AI科学家、图灵奖获得者杨力昆的观点:“视频生成模型不理解基本物理学,更不说用人体了。”

更易被用户感知的是,Gen-3在视觉审美和电影感方面取得了显著进步。我们使用相同的提示词,从细节处理、场景生成、动作幅度、电影感等维度,对比了RunwayGen-2和Gen-3之间的区别,大家可以直观感受下AI视频模型的迭代速度。

可谓是“AI一天,人间一年”。

Runway王者回归,文生视频大战走向白热化

作为文生视频工具,Gen-3更易用了。

与前一代相比,Gen-3在时间控制的精确度、人物角色的真实感以及对多场景切换的语义理解方面均有显著提升,能够生成更加流畅和动幅更大的视频内容。

此前,由于文生视频模型可控性不足,我们采用“文生图片”再到“图生视频”的工作流制作了一支AI科幻短片。

如今,Gen-3的面世使得从文本到视频直出的工作流成为可能。

据Runway官方教程介绍,Gen-3目前支持720p分辨率的视频生成,并且能够适应从简单到复杂的各种提示词结构。

一般情况下,文本提示越详细,Gen-3的表现就越出色。可以在文本提示中包含详细的视觉元素,如主题、场景、照明、摄像机、动作等。此外,Gen-3Alpha还可以根据主题动作、摄像机动作、速度、过渡等进行提示。

官方给出的示例提示词结构是:视觉描述 摄像机运动。

例如——

视觉:一个舒适的客厅里的枕头堡垒。枕头堡垒由各种被子、布料和枕头制成。

摄像机运动:手持摄像机平稳地放大到枕头堡垒的入口,露出内部的古老城堡。

Runway首席技术官AnastasisGermanidis曾发文表示,在多模态模型中,“控制”(即可控性)是关键。

视频生成模型在可控性方面还有很大的提升空间。尤其在文生视频领域,视频是多帧图像的组合,这要求AI模型不仅要在单帧图像上,而且要在视频的连续性和时间维度上准确理解语义。

Runway选择卷AI视频生成的“可控性”,推出了多种辅助控制功能,如运动笔刷、高级摄像机控制、导演模式等。

据悉,Gen-3这次在视频和图像方面进行了联合训练,训练团队由研究科学家、工程师和艺术家组成,在响应各种影像风格和电影术语上表现更好。

接下来也将会陆续支持Runway的文本到视频、图像到视频和文本到图像工具、现有的控制功能以及即将推出的工具提供支持,用于更精细地控制结构、风格和运动。

面向公众开放的这版Gen-3也仅仅只是新系列模型中最小的公开模型。

Runway联合创始人兼CEOCrisValenzuela发布的X推文

接下来,Gen-3的模型迭代与功能更新值得广大AI爱好者、视频创作者和影视工作者持续关注。

Sora只是“卖家秀”,AI视频应用落地要看“买家秀”

今年6月始,AI视频生成领域掀起了一波应用落地潮。先后有快手可灵、LumaDreamMachine、RunwayGen-3等视频模型面向公众开放使用。

三家产品各有特色。可灵在对物理世界的理解和吃播类视频上拥有独特优势;DreamMachine的图生视频在动幅和想象力表现上十分惊艳;RunwayGen-3则在文生视频的语义理解上跃升了一个台阶。

其中DreamMachine和Gen-3都在视觉画面上拥有更好的审美表现。

早前我们对比过Gen-3与快手可灵在相同提示词下生成的视频对比,大家可以直观感受下:

一张流传甚广的梗图足以说明,Runway发布的Gen-3模型在不少玩家心中跃升为AI视频工具中的Top1选择:

结合玩家反馈和“AI新榜”上手实测,可以说在当前的AI视频生成技术下,使用单一提示生成长篇且连贯的视频仍是一大挑战。

目前AI视频生成技术更适合应用于短视频和短片制作,而非具有完整叙事结构的长篇视频。

其次,成本也是AI视频生成应用落地以及商业化的一个重要考量维度。

对于财大气粗的好莱坞大制片厂来说,使用生成式AI来创建背景场景或次要镜头可以简化制作过程并降低成本。像Runway一类的AI视频工具已经开始在专业影视制作中得到应用。

而对个体创作者、中小型企业来说,AI视频生成的算力成本仍然昂贵。以RunwayGen-3为例,生成一个10秒的视频大约需要消耗100点数,而月度会员费用是15美元(约人民币110元左右),总共只有1150点数。

也就是说,仅生成10个10秒的视频,就需花费约110元人民币。

这还没算上,现阶段生成视频结果不稳定导致的整体使用成本骤升。

底层模型能力提升与成本控制,是未来AI视频模型落地应用以及商业化的两大关键问题。从Sora再到如今的Runway,文生视频这一“多模态AIGC圣杯”将鹿死谁手还尚未可知,从这一角度来看,AI视频生成领域还远远没有迎来它的“ChatGPT时刻”。