随着人工智能技术的飞速发展,大模型应用已成为推动各行各业创新的关键力量。这些大模型,如GPT3、BERT等,以其强大的数据处理能力和学习能力,正在改变我们的工作方式和生活方式。然而,大模型的训练和应用对计算资源的需求极高,这直接推动了对高性能芯片的需求。本文将探讨芯片技术的快速迭代如何优化大模型应用,并分析这一趋势对未来技术发展的影响。

1. 芯片技术与大模型应用的关联

芯片是现代电子设备的核心,其性能直接决定了设备的运行速度和处理能力。在大模型应用中,芯片的作用尤为突出。大模型的训练通常需要处理海量的数据,进行复杂的数学运算,这要求芯片具备高度的并行计算能力和数据处理速度。因此,芯片技术的每一次进步都极大地推动了大模型应用的发展。

2. 芯片技术的快速迭代

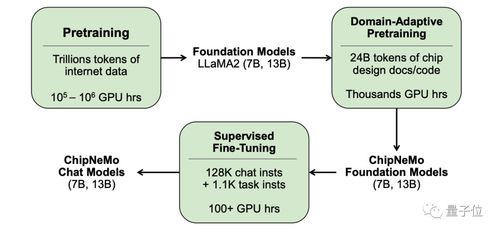

近年来,芯片技术经历了快速的发展。从传统的CPU到GPU,再到专门为机器学习设计的TPU,每一次技术的革新都带来了计算能力的巨大提升。特别是GPU和TPU的出现,它们在并行计算方面的优势使得大模型的训练时间大大缩短,成本也相应降低。

芯片制造工艺的进步也极大地推动了性能的提升。从14nm到7nm,再到最新的5nm工艺,每一代工艺的进步也将芯片的能效比提升到了新的高度。这不仅意味着更快的处理速度,也意味着在相同的功耗下可以实现更复杂的计算任务。

3. 大模型应用的优化

随着芯片技术的迭代,大模型应用也在不断优化。训练时间的缩短使得模型的迭代更新更加迅速。研究人员可以更快地测试新的算法和模型结构,加速了人工智能技术的创新。其次,成本的降低使得更多的企业和研究机构能够参与到大型模型的研究和应用中,促进了技术的普及和应用的多样化。

芯片技术的进步将使得大模型在移动设备和边缘计算中的应用成为可能。这将极大地扩展大模型的应用场景,从云端到终端,从数据中心到个人设备,大模型的能力将被更广泛地利用。

4. 未来展望

展望未来,芯片技术的持续进步将是大模型应用发展的关键。随着量子计算、神经形态计算等前沿技术的发展,未来的芯片将具备更强的计算能力和更高的能效比。这将使得大模型能够处理更加复杂的任务,实现更加精细化的应用。

随着芯片技术的迭代,大模型的训练和应用将更加注重能效比和环境影响。绿色计算将成为未来发展的重要方向,如何在保证性能的同时减少能源消耗,将是芯片设计者和应用开发者共同面临的挑战。

5. 结论

芯片技术的快速迭代是推动大模型应用优化的关键因素。随着芯片性能的不断提升和成本的降低,大模型的应用将更加广泛,其对社会和经济的影响也将更加深远。未来,我们期待芯片技术与大模型应用的深度融合,共同开启人工智能的新篇章。